编码

慢速外设接口

机器人平台

华为云

图书馆选座系统

寒武纪笔试

globalmapper

概率论

flyfish

委托传值

xml

网络编程

密度泛函理论

自回归

cisp考试难度

一卡通数据分析

信息系统项目管理师

网页设计与制作

scrapy

个人博客

MoE

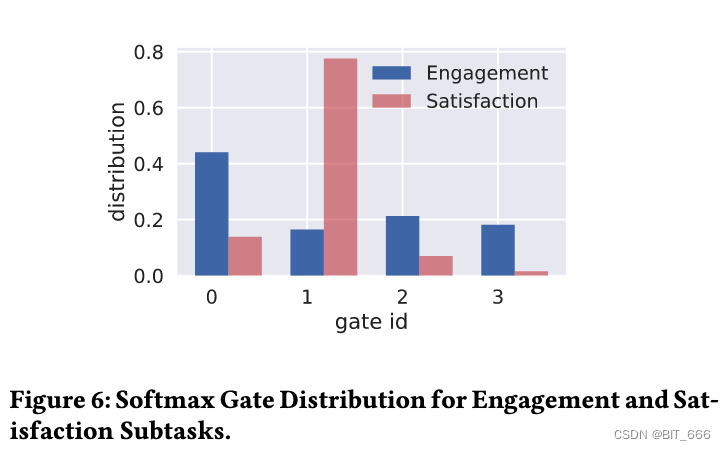

2024/4/13 1:14:22深度学习 - 44.MMOE 与 Gate 之多目标学习

目录

一.引言

二.摘要 Abstract

三.介绍 Introduction

四.相关工作 RELATED WORK

1.DNN 中的多任务学习

2.SubNet 集成与 Expert 混合

3.多任务学习应用

五.建模方法 MODELING APPROACHES

1.Shared-bottom Multi-task Model

2.Mixture-of-Experts

3.Multi-gate Mixt…

极智一周 | MoE、FlashAttention、PTQ、MI300禁令、H100利润空间、戴口罩检测 And so on

欢迎关注我的公众号 [极智视界],获取我的更多技术分享

大家好,我是极智视界,带来本周的 [极智一周],关键词:MoE、FlashAttention、PTQ、MI300禁令、H100利润空间、戴口罩检测 And so on。 邀您加入我的知识星球「极智…

『大模型笔记』混合专家模型(Mixed Expert Models,简称 MoEs)

混合专家模型(Mixed Expert Models,MoE) 文章目录 1. 什么是混合专家模型?2. MoE的PyTorch示例代码3. MoE优缺点4. 参考文章混合专家模型(Mixed Expert Models,MoE)1. 什么是混合专家模型?

2. MoE的PyTorch示例代码

MoE模型性能还能更上一层楼?一次QLoRA微调实践

Fine-Tuning Mixtral 8x7B with QLoRA:Enhancing Model Performance 🚀 编者按:最近,混合专家(Mixture of Experts,MoE)这种模型设计策略展现出了卓越的语言理解能力,如何在此基础上进一步提升 MoE 模型的性能成为业界…

LIMoE:使用MoE学习多个模态

文章链接:Multimodal Contrastive Learning with LIMoE: the Language-Image Mixture of Experts

发表期刊(会议): NeurIPS 2022 目录 1.背景介绍稀疏模型 2.内容摘要Sparse Mixture-of-Experts ModelsContrastive LearningExperiment Analy…

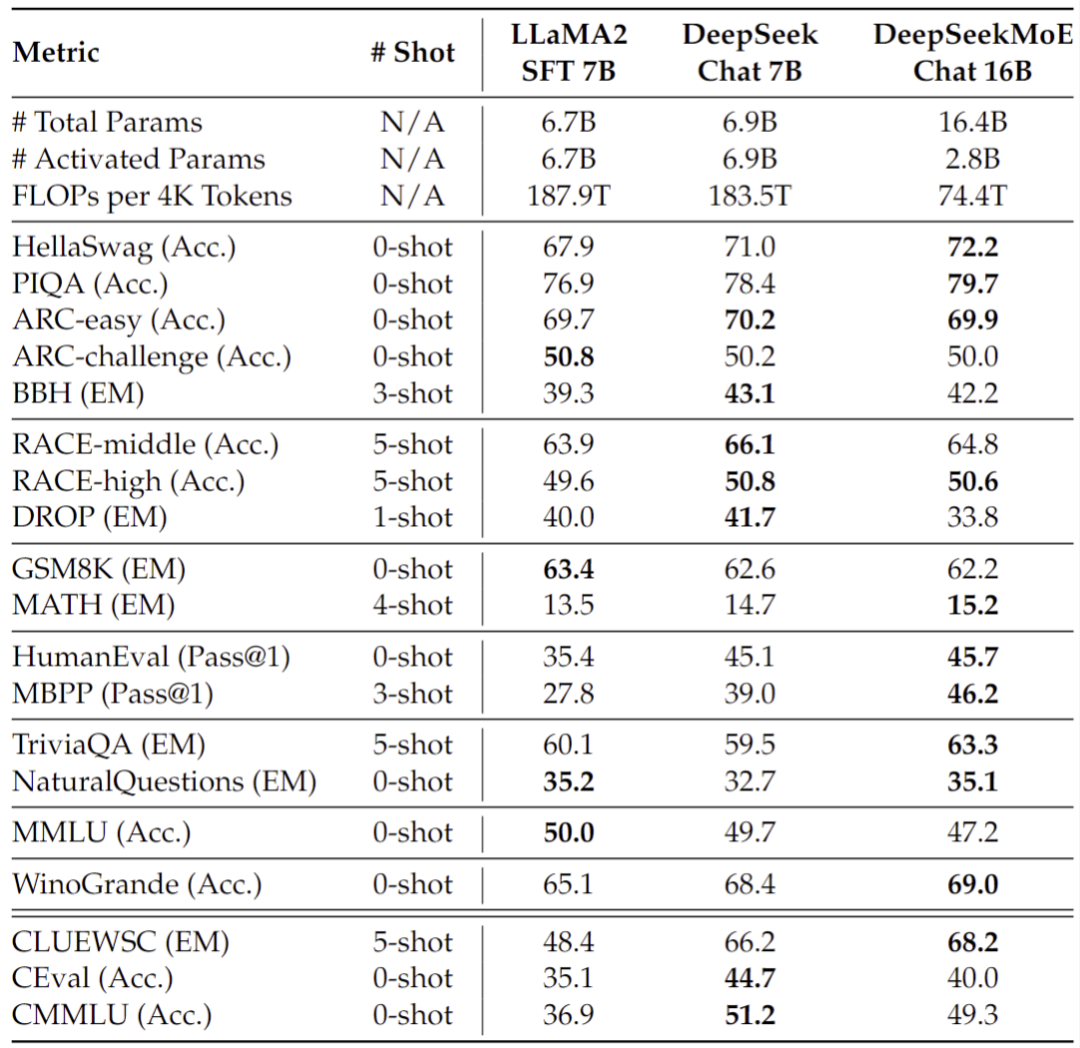

深度求索开源国内首个 MoE 大模型 | DeepSeekMoE:在专家混合语言模型中实现终极专家专业化

文章目录 一、前言二、主要内容三、总结 🍉 CSDN 叶庭云:https://yetingyun.blog.csdn.net/ 一、前言 在大语言模型时代,混合专家模型(MoE)是一种很有前途的架构,用于在扩展模型参数时管理计算成本。然而&a…

Janus: 逆向思维,以数据为中心的MoE训练范式

文章链接:Janus: A Unified Distributed Training Framework for Sparse Mixture-of-Experts Models

发表会议: ACM SIGCOMM 2023 (计算机网络顶会) 目录 1.背景介绍all-to-allData-centric Paradigm 2.内容摘要关键技术Janus细粒度任务调度拓扑感知优先级策略预取…

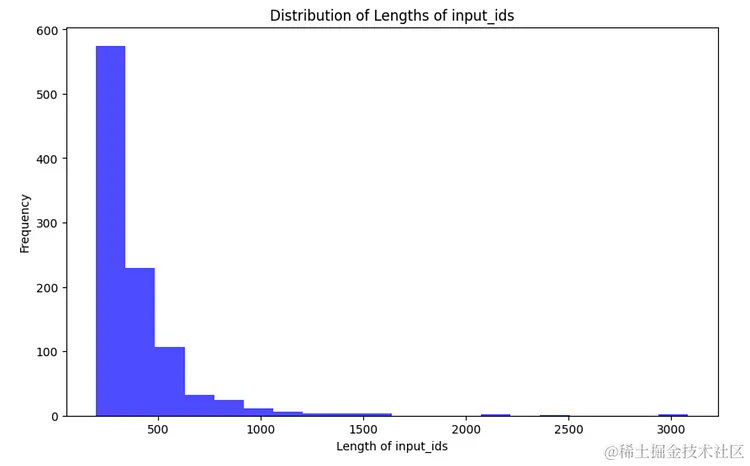

Mixtral Moe代码解读

一直对稀疏专家网络好奇,有些专家没被选中,那么梯度是否为0,这一轮被选中有梯度,下一轮没被选中无梯度,模型可以训练收敛吗? 由于每个token都会选择topk个专家,所以在每一轮epoch中,…

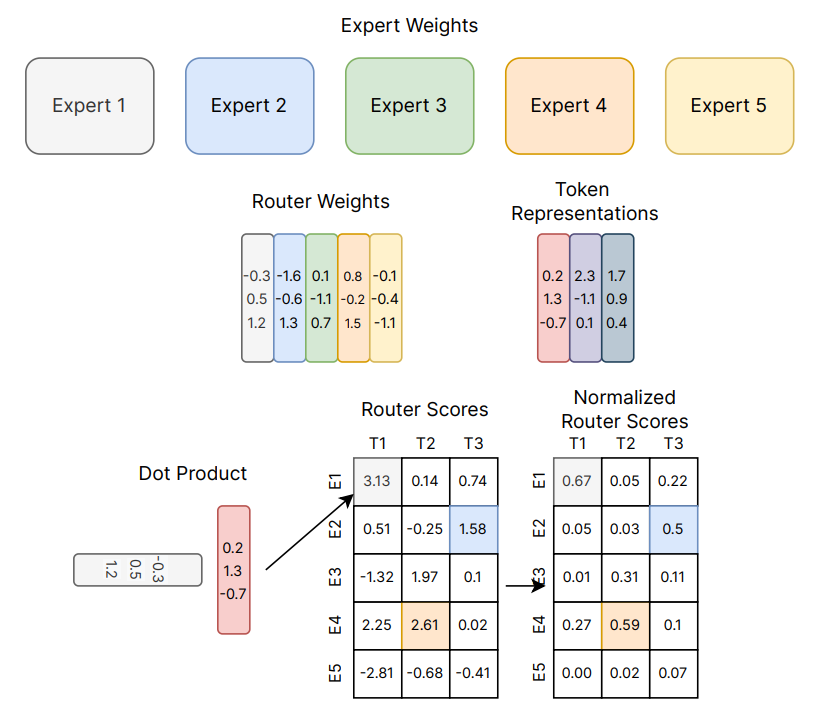

大模型面试准备(九):简单透彻理解MoE

节前,我们组织了一场算法岗技术&面试讨论会,邀请了一些互联网大厂朋友、参加社招和校招面试的同学,针对大模型技术趋势、大模型落地项目经验分享、新手如何入门算法岗、该如何备战、面试常考点分享等热门话题进行了深入的讨论。 合集在这…

LLM之makeMoE:makeMoE的简介、安装和使用方法、案例应用之详细攻略

LLM之makeMoE:makeMoE的简介、安装和使用方法、案例应用之详细攻略 目录

makeMoE的简介

1、对比makemore

2、相关代码文件

makMoE_from_Scratch.ipynb文件

makeMoE_Concise.ipynb文件

makeMoE的安装和使用方法

1、基于Databricks使用单个A100进行开发

makeM…

MMoE: 基于多门专家混合的多任务学习任务关系建模

文章链接:Modeling Task Relationships in Multi-task Learning with Multi-gate Mixture-of-Experts

发表会议: KKD 2018 (Knowledge Discovery and Data Mining,数据挖掘领域顶会) 目录 1.背景介绍Recommendation SystemMulti-…